Schon mal was von Graphen gehört? Dieser geniale Rohstoff wird momentan auf vielen Fronten kommerzialisiert und die Forschung verspricht in der Tat bahnbrechende Innovationen. Hier die Liste, warum dieser Rohstoff unbedingt auf jeden vernünftigen Technologie Radar gehört. „Graphen ist krasser als Chuck Norris“ weiterlesen

Roboter: Werden wir (srsly?) alle arbeitslos?

Die Industrialisierung im 19. Jahrhundert führte in ganz Europa zu Protesten. Historiker bezeichnen dies als den Maschinensturm. Heute wiederholt sich eine ähnliche Dynamik: Ein (kleiner) Sturm gegen Roboter. Befürchtet werden momentan hauptsächlich mehr Arbeitslose. Doch ist diese Skepsis gerechtfertigt?

Es lohnt sich eine Auseinandersetzungen mit den Statistiken. Entscheidend dabei ist das Verhältnis der erwerbsfähigen und der tatsächlich erwerbstätigen Bevölkerung. In der Schweiz lag die Erwerbstätigenquote 1996 bei 79.4%. Zwanzig Jahre später steigerte sich das Verhältnis zwischen Erwerbstätigen und der Bevölkerung im 2014 auf 82.3%. In der EU stieg die Erwerbstätigenquote zwischen 2002 und 2014 von 66.7% auf 69.2%. Einzig in den USA sank diese Quote von einer Spitze von beinahe 77% 1999 auf 71.8% im 2014.

Welches aber sind die möglichen Einflussfaktoren, dass Roboter die Arbeitslosenzahl nach oben drücken? Es bietet sich die Auseinandersetzung mit zwei Aspekten an: Künstliche Intelligenz und die Frage, was nicht automatisierbar ist.

Eine wichtige Erkenntnis des technologischen Wandels ist, dass schwierige Herausforderungen einfach lösbar sind und scheinbar einfache Herausforderungen nur mit hohem Aufwand zu lösen sind. Anders gesagt: Google DeepMind kann in einem komplexen Strategiespiel den Meister des Fachs besiegen. Andererseits stellen sich bei der Simulation von einfacher Grundmotorik immer noch kostspielige Entwicklungshürden. Dieses Moravec‘ Paradox wurde in den 80er Jahren unter anderem von Hans Moravec beschrieben. Was aber wenn auch die einfachen (aber komplexen) Probleme durch künstliche Intelligenz und Roboter gelöst werden? Dazu braucht es eine Abgrenzung der Frage, was nicht automatisiert werden kann.

Eine gute Zusammenfassung bietet Beat Döbeli in seinem Buch Mehr als 0 und 1. Basierend auf den Erkenntnissen von Klaus Haefner hält Döbeli fest, dass Teamfähigkeit, Sozialkompetenz, Kreativität und Kommunikationskompetenzen nicht automatisierbare Fähigkeiten sind. Er ergänzt, dass mit diesen Kompetenzen „weniger Substituierbare“ auszubilden sind. Damit werden neuen Anforderungen an unser Bildungssystem gestellt. Querdenkende Kreativgeister mit interkulturellen Führungsqualitäten werden gefragt sein!

Dies tönt nach einem elitären Verständnis von Erwerbsarbeit. „Warum gibt es immer noch so viele Jobs?“ fragt sich daher der MIT-Forscher David Autor berechtigterweise. Eine der zentralen Beobachtung seines Essay ist, dass Journalisten und Experten dazu neigen, die Situation generell zu übertreiben. Er präzisiert zudem, dass die Automatisierung die Produktivität steigern und das Einkommen erhöhen wird. Dadurch wird die Nachfrage nach Arbeitskräften nicht sinken. Die Verbesserung von AI, Robotern und gesteigerte Rechenleistungen verändern jedoch den Charakter von Arbeit und was dafür bezahlt wird. Gemäss Autor droht dabei ein weiteres Aufgehen der Einkommensschere.

Abschliessend betrachtet führt mich dieser Blog Beitrag zu folgender Frage: Wie viele arbeitslose Hufschmiede kennen Sie? Voilà! Trotz fortschreitender Automatisierung gehe ich davon aus, dass der Arbeitsmarkt die veränderte Nachfrage nach neuen Kompetenzen selber regeln wird. Es wird jedoch künftig wichtiger werden, dass die gefragte Fähigkeiten zwischen dem Arbeitsmarkt und dem Bildungssystem noch besser abgeglichen werden.

Foto von Unsplash

Rechenleistung: Eine Ära geht zu Ende

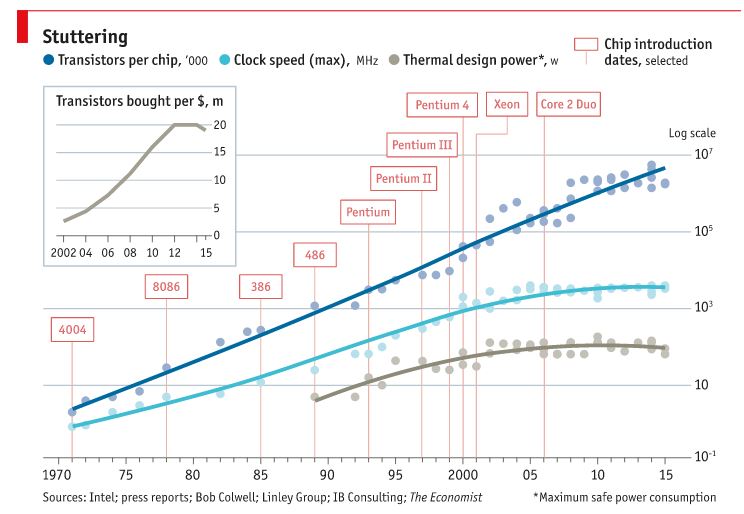

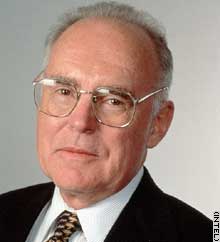

In den letzten 50 Jahren hat sich die Rechenleistung von Computern durchschnittlich alle 24 Monate verdoppelt. In weiser Voraussicht hat dies der Co-Founder von Intel festgehalten. Das sogenannte ‚Moore’s Law‘ gilt als selbsterfüllende Prophezeiung und als kluge PR von Intel. (vgl. auch Artikel vom Februar 2016). Nun wurde das Gesetz zum ersten Mal nicht mehr eingehalten. Was hat dies zu bedeuten?

Es gibt heute Prozessoren, die einen Durchmesser von lediglich 100 Atomen haben. Logischerweise ist die physische Entwicklung von Kleiner-ist-Besser dadurch limitiert und führt zu wirtschaftlich schwer tragbaren Entwicklungskosten. Trotz aller Innovationen ist die Verkleinerung von Prozessoren eine äusserst kostspielige Investition. Dies führte u.a. dazu, dass die Geschwindigkeit von Prozessoren seit einiger Zeit nicht mehr gesteigert werden konnte.

Die Ära der Voraussage von Moore ist faktisch beendet. Daraus ergibt sich die 100 Dollar Frage: Wie werden sich unsere Computer in den nächsten 10 Jahren weiterentwickeln?

Chiphersteller wie Samsung entwickeln neue Konzepte, um die Transistoren noch kleiner zu machen (Stichwort finFET). 5 Nanometer sollen demnach bis 2020 erreichbar sein. Danach braucht es radikalere Methoden, um weitere Leistungssteigerungen erzielen zu können. Auf welche Entwicklungen lohnt es sich zu schauen?

Es gibt exotische Ansätze, dass durch die Quantenmechanik die Effizienz von Prozessoren nochmals um ein Vielfaches gesteigert werden kann. Andere Forscher versuchen, ein Hirn biologisch nachzubauen um damit reale Rechenleistung zu erzielen. Vielversprechend erscheinen mir Ansätze von hoher Vernetzung (auch Schwarmintelligenz), welche durch das IoT die Rechenleistungen potenzieren will. Es gilt, die besten Projekte im Auge zu behalten.

Einen umfangreicher Artikel zum Ende vom Moor’schen Gesetz findet sich im Economist.

Zukunft der Digitalen Bildung in der Schweiz

An der Schlussveranstaltung des Projektes ‚Schule im Netz‘ konstatierte Doris Leuthard im Jahr 2007, dass der Bildungssektor nun gerüstet sei für die Digitalisierung. Diese Schlussfolgerung erscheint neun Jahre später, mit einigen Ausnahmen, etwas voreilig.

Ich bin Mitbegründer des Vereins „Digitale Bildung Schweiz“ und in verschiedenen Dachverbänden zu diesem Thema engagiert. Insbesondere der Austausch mit den Bildungsprofis gibt Anlass zu folgender Frage: Wie kann die Digitalisierung von öffentlichen Schulen gefördert werden? Dazu habe ich drei Diskussionsgrundlagen skizziert.

Erstens: Die Rolle der Lehrpersonen

Auf seinem Blog spricht Philipp Wampfler davon, dass es keine „Digital Natives“ und „Digital Immigrants“ gibt. Sein Ansatz geht vielmehr davon aus, dass ein „selbstverständlicher Umgang“ mit digitalen Möglichkeiten von allen Personen, unabhängig vom Geburtsjahr, erworben werden kann. Wampfler hält in seinem Buch ‚Generation Social Media‘ zudem fest, dass „zwischen den spielerischen automatischen Lernprozessen und dem bewussten Gestalten von Lernumgebungen, in denen dank Begleitung erfahrener Coaches Grundfertigkeiten sicher angeeignet werden können“ unterschieden werden muss.

Lehrpersonen sind damit konfrontiert, dass bereits 1. Klässer die digitalen Geräte virtuos beherrschen. Dieses genuine Nutzungsverhalten ist aber nicht gleichzustellen mit der Medienkompetenz. Hier können sich Lehrpersonen als Gestalter von digitalen Lernprozessen positionieren, welche einen kompetenten Umgang mit Medien vermitteln. Orientierungshilfe geben dabei die Leuchttürme der digitalen Bildung, wie sie beispielsweise an der Primarschule in Arth-Goldau oder im Schulhaus Moosmatt in Luzern zu finden sind.

Zweitens: Kompetenz vor Technologie

Wir erinnern uns an die Sprachlabore, die 386er und 486er in den Schulzimmern. Der pädagogische Mehrwert dieser Investitionen war sehr bescheiden. In den letzten 25 Jahren hat man sich im Bildungssektor stets um die Frage gekümmert, welche Technologie ins Schulzimmer gehört. Der Global ICT Report 2015 des WEF kommt zu einer gegenteiligen Erkenntnis: Lehrpersonen müssen zuerst über entsprechende didaktische Fähigkeiten verfügen, um den Unterricht digital gestalten zu können. Dafür braucht es angepasste Angebote in der Aus- und Weiterbildung von Lehrpersonen.

Drittens: Umsetzung von Unten nach Oben

Die Digitalisierung des Unterrichtsmaterials muss unabhängig von Anbietern oder Firmen gemacht werden. Dabei bieten sich Open Educational Ressorces (OER) an, also von den Nutzern selbst generierte Lerninhalte. Der Verein „Digitale Bildung Schweiz“ hat hierfür die schwedische Erfolgsgeschichte Learnify in die Schweiz geholt. Learnify ist unabhängig von einem Betriebssystem oder einem Gerät und hat drei zentrale Vorteile:

- Die im Unterricht notwendigen Unterlagen können digitalisiert abgegeben werden. Dies kann ein statischer Text sein oder eine interaktive Lernressource. Somit sind kollaborative Lernformen und effektives netzbasiertes Lernen möglich.

- Die (multimedialen) Lerndokumente werden in eine Lern-Management Umgebung eingebettet – Lehrpersonen können damit Klassen, Gruppen oder einzelne Schüler individuell fördern, Diskussionen moderieren sowie den Fortschritt von Einzelnen begleiten.

- Andere Anbieter von digitalen Lerninhalten werden unkompliziert in Learnify eingebunden. Neben den OER Ressourcen entsteht so eine Bibliothek von Inhalten – beispielsweise das Schulfernsehen oder eBooks.

5G Mobilfunk

Mit der nächsten Mobilfunk Generation 5G sind Übertragungsraten von bis zu 10’000 MBits/s möglich. Zum Vergleich: Als schnell gelten heute Glasfaserverbindungen mit 1’000 MBits/s. Das neue Netz wird damit 10x schneller sein. Dieser nächste Schritt wird für die Nutzung des mobilen Internets und die Möglichkeiten des IoT wichtige Türen öffnen. Doch wo steht die Schweiz?

Die Einführung von 5G in der Schweiz ist ab 2020 geplant. So hält es jedenfalls die Swisscom fest. Dieser Zeitplan ist im internationalen Vergleich vertretbar. In der koreanischen Wiege von 5G geht man von einer Kommerzialisierung bis 2020 aus. Das europäische Netzwerk rechnet mit einer Einführung ab 2020. Günther Öttinger, der quasi CIO der EU, engagiert sich umfassend für eine moderne Infrastruktur.

An dieser Stelle muss man sich mit dem Regulator in der Schweiz befassen. Komplizierte Bewilligungsverfahren und einschränkende Auflagen bedrohen eine zeitnahe Einführung von neuen Mobilfunkstandards. Zudem scheint die aktuelle Revision des Fernmeldegesetzes (FMG) wenig förderliches zu enthalten, um den Wettbewerb im Ausbau der Kommunikationsnetze zu fördern. Interessanterweise werden mit dieser Revision nur die Kupferleitungen reguliert. Glasfaser und Mobilfunk bleiben vorerst unreguliert und werden in einem zweiten Schritt angepasst.

Es besteht die konkrete Gefahr, dass die politische Debatte dazu führt, dass wir den Anschluss verpassen. Dies ist aus folgenden Gründen ein Risiko:

- Mobiles Internet ist zentral: Bereits heute finden 80% der Internetzugriffe über mobile Geräte statt – der Mobilfunk ist das Rückgrat!

- Hinterfragung der Infrastruktur: Ein leistungsfähiges 5G wird eine direkte Konkurrenz zum Kupfer- und Glasfaserkabel – wo also in den nächsten vier Jahren investieren?

Wir haben noch zwei FMG Revisionen vor uns, während der Rest der Welt sich auf die Einführung von 5G vorbereitet. Verfolgen kann man diese globale Debatte am kommenden Mobile World Congress in Barcelona. Wir müssen dranbleiben!

Foto von Unsplash

Zwei wegweisende ‚Mobile Health‘ Projekte

Dass wir unsere Schritte zählen (10’000 sind mein Benchmark) ist mittlerweile selbstverständlich. Smartphones messen den Puls, zeichnen die Sauerstoffsättigung des Blutes auf, können das Schlafverhalten festhalten und aggregieren diese Vitalitätsdaten zu einem Gesamtbild.

Technisch kommen dabei meistens optische Sensoren, GPS sowie die manuelle Eingabe zum Einsatz. Trotzdem ist der Mehrwert noch nicht berauschend. Mein Arzt lehnte beispielsweise den Einbezug dieser Daten in seine Diagnose ab. Er hatte zu grosse Vorbehalte betreffend der Zuverlässigkeit meines Wearables. Es scheint, dass ein nächster technologischer Schritt notwendig ist. Dabei sind zwei Vorhaben interessant.

Das vielbesprochene Projekt ‚Smart Lens‘ von Google und Novarits wird im 2016 in die Testphase gehen. Mit der intelligenten Linse ist unter anderem die lückenlose Messung des Blutzuckers möglich. Wird dieser Wearable mit einem integrierten Display ausgeliefert werde ich Linsenträger!

Ein etwas konkreteres Projekt wurde Anfang 2016 vorgestellt. Forscher der University of California-Berkeley und der Standford University School of Medicine messen den Schweiss auf der Haut. Durch flexible Sensoren in einem Stirn- oder Armband werden laufend Aufzeichnungen über die komplexe Zusammensetzung von Schweiss gemacht. Mit diesem Wearable können beispielsweise Informationen über den Stoffwechsel oder die vorhandenen Elektrolyten pausenlos erhoben werden. Die Forschenden gehen davon aus, dass dadurch Krankheiten besser erkannt und behandelt werden können. Auch für Spitzensportler dürfte der Wearable zur Leistungssteigerung interessant sein. Ziel ist es nun, ein markttaugliches Gerät zu entwickeln.

Mein Rezept für die Uberisierung

Uber ist nicht Shared Economy. Es handelt sich bei Uber um Collaborative Economy, bei welcher P2P-Beziehungen einen wirtschaftlichen Mehrwert ergeben. Soweit diese Klarstellung. Nun zum wesentlichen Teil.

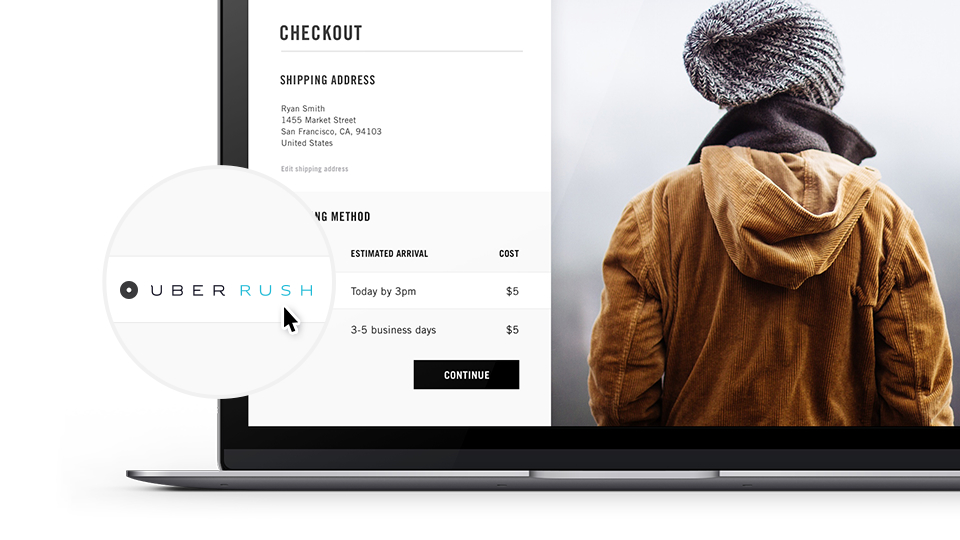

Diese Woche bin ich auf ein Angebot von Uber gestossen, welches ich als wegweisend erachte. Einen grossen Nutzen daraus sollte sich unter anderem der Detailhandel versprechen. Es geht dabei um nichts weniger als die Digitalisierung der Detaillisten .

Mit UberRUSH (Bild von Uber) gibt es seit geraumer Zeit ein Angebot für Firmen, welches bei geringen Lieferkosten und keinem Overhead eine effiziente Logistik gewährleistet. Will beispielsweise ein Blumenhändler die bestellten Rosen versenden, erledigt er dies einfach via UberRUSH. Zeitnah und ohne eine eigene Fahrzeugflotte.

Die Erwartungen an überschaubare Lieferzeiten sind heute schon hoch und werden künftig noch ambitionierter. Die Zeit von der Bestellung zur Lieferung an die Haustüre wird in Stunden kalkuliert; 60 Minuten gelten als ideal. Dies ist für die helvetischen Detailhändler eine realer Benchmark.

Mit UberRUSH API besteht neu die Möglichkeit, dass der Blumenhändler UberRUSH direkt in seine digitale Infrastruktur einbinden kann. Damit wird eine kundennahe Umsetzung möglich, welche mehr Effizienz verspricht.

Betrachtet man dies nun betriebswirtschaftlich, wird folgendes klar: Das offene System von Uber ermöglicht Firmen eine klassische Form der horizontalen Integration, mit welcher die eigene Wertschöpfung optimiert und im besten Fall gesteigert werden kann. Diese Konzept der integrierten Geschäftsprozesse ist hinlänglich bekannt und muss nun für die Digitalisierung genutzt werden. Die umsichtige Eingliederung von Drittanbietern in die eigene Wertschöpfung ist meines Erachtens der Blueprint, wie Unternehmen gewinnbringend webbasierte Geschäftsmodelle umsetzen können.

Die Vor- oder Rückwärtsintegration ist das Rezept, um von der Uberisierung zu profitieren und wettbewerbsfähig zu bleiben. Dazu braucht es unternehmerische Weitsicht und einen Regulator, der die Möglichkeiten der integrierten Wertschöpfung clever antizipiert.

Daten für das Gemeinwohl

Es ist 1965 und der Co-Founder von Intel macht eine Voraussage. Gordon E. Moore (Titelbild von Intel) orakelt, dass sich die Rechenleistung von Prozessoren jedes zweite Jahr verdoppeln wird. In den letzen 50 Jahren hat sich Moores Law bestätigt. Und ein Ende dieser Entwicklung ist nicht in Sicht. (Notiz an mich selber: Graphene wird dabei entscheidend sein!).

Im Vorwort der Deutschen Ausgabe von Erik Brynjolfsson’s und Andrew McAfee’s WEF 2016 Pflichtlektüre „The Second Machine Age“ macht Prof. Dr. Herbert Henzler im Zusammenhang mit dem exponentiellen Wachstum der Rechenleistung einen interessanten Hinweis. Durch das Internet der Dinge und die gute Konnektivität steige auch die Menge der gesammelten Daten; Stichwort Big Data. Es stellt sich die Frage, wie sich das Wachstum der gesammelten Daten aus dem Internet (der Dinge) entwickelt: Verhält dieses sich parallel zum Moor’schen Gesetz oder multiplizierend dazu? Philipp Evans hat die Frage über Big Data in einem Aufsatz gut zusammengefasst. Basierend auf Evans ergeben sich folgende Big Data Trends:

- Trend 1: Mit dem Smartphone ins schnelle Internet: Die Zugänge zu schnellem Internet in den G20-Ländern wächst rapide. Im 2010 waren es lediglich 800 Millionen Zugänge und die Hälfte davon über mobile Geräte. Im 2015 waren es bereits 2.7 Milliarden Zugänge und 80% davon mobil. Einen weiteren Sprung wird es mit der Einführung von 5G Standards geben.

- Trend 2: Rasantes Wachstum des Datenberges: Innerhalb der letzten zwei Jahre wurde 90% der heute gespeicherten Daten gesammelt; 99% davon sind digitalisiert.

- Trend 3: Datenvolumen werden erhöht: Die Speicherkapazität verdoppelt sich innerhalb von 13 Monaten; der Datendurchsatz bei Glasfaser verdoppelt sich innerhalb von neun Monaten.

- Trend 4: IP fähige Sensoren werden günstig: Bis ins Jahr 2050 werden global 50 Milliarden Sensoren ins Internet rapportieren. Etwas mutigere Schätzungen rechnen mit über 10 Billionen (10^12) IP-Sensoren. Schon heute beträgt der Preis für einen RFID-Tag nur wenige Cents.

- Trend 5: Social Media: Facebook hatte Ende 2015 1.55 Milliarden User und 80% nutzen Social Media via mobile Endgeräte. Der daraus resultierende Datenberg ist eine verlässliche Goldader.

Kollidieren nun die Entwicklung der Prozessoren nach Moores Law sowie die Trends im Bereich Big Data, darf man von einer echten Disruption sprechen. Vor dieser Kollision und deren Auswirkungen wird auch umfassend gewarnt. So verlangt der CEO von Accenture, dass die soziale Wirkung der Digitalisierung verstärkt im Auge behalten werden muss. Doch was ist hier zu tun?

Man spricht hierbei von einer digitalen Selbstbestimmung, also dem Bürger einen informierten und kompetenten Umgang mit seinen Daten zutrauen ermöglichen. Der Schlüssel dazu ist gezielte Bildung. Zusätzlich schlage ich jedoch vor, dass Daten dem Gemeinwohl zur Verfügung gestellt werden. Es gibt hierzu Projekte von globalen Unternehmen, die „Big Data for Humanity“ erfolgreich betreiben.

Mit „Big Data for the Public Good“ empfehle ich aber einen grundlegenderen Ansatz, bei welchem der Staat, die Zivilgesellschaft und die Wirtschaft gleichermassen profitieren. Richtig eingesetzt fördert dies den Wohlstand und steigert die Akzeptanz von datenbasierten Geschäftsmodellen. Die möglichen Umsetzungen dazu werde ich auf diesem Blog sammeln – ich bleibe dran!

Crispr: Eine Zukunft ohne Krankheiten

Forschenden ist es gelungen, einen einfachen Schutzmechanismus von Zellen so umzuprogrammieren, dass damit gezielt DNA-Sequenzen verändert werden können. Die Methode nennt sich etwas umständlich Crispr/Cas9 und ist im eigentlichen Sinne genetische Chirurgie. Damit können präzise Eingriffe an bestimmten Sequenzen der DNA kostengünstig und mit hohen Erfolgsaussichten verändert werden. Vereinfacht gesagt bedient sich Crispr einer Suchen & Ersetzen Funktion, um unerwünschtes mit einer erwünschten Alternative zu ersetzen. Krebs raus, Wohlbefinden rein.

Unter gewissen Voraussetzungen wirken diese Eingriffe nachhaltig. Nämlich so, dass die Veränderungen in der DNA-Sequenz an die nächste Generation vererbt werden.

Was aber, wenn die Methode eingesetzt wird um Parkinson oder Stoffwechselkrankheiten zu eliminieren? Bevor es soweit ist, werden wir uns einer anspruchsvollen Diskussion stellen müssen. Es gilt gesellschaftlich und politisch zu klären, unter welchen Voraussetzungen das Skalpell an menschlichen, tierischen und pflanzlichen Genomen angesetzt werden darf.

Eine führende Rolle in der Entwicklung und der Diskussion über Gen-Editierung nimmt Jennifer Doudna von der Universität Berkeley ein. Deren Blog „Innovative Genomics Initiative“ gilt es im Auge zu behalten. Das wird der Ort sein, wo in den nächsten Jahren ein Nobelpreis verkündet werden kann.

Nebenbei: Wie wird die Pharamindustrie auf eine skizzierte Zukunft ohne Krankheiten reagieren?

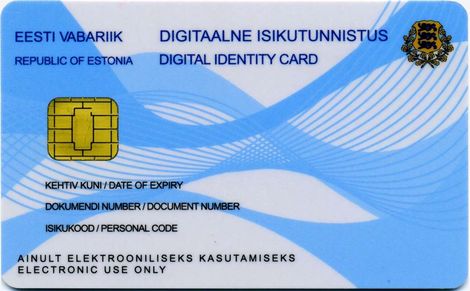

Eidgenössische Digitale Staatsbürgerschaft

Die digitale Morgenröte scheint am schönsten in Estland. Das ist keine Prosa sondern Realpolitik. Die estnische Regierung setzt schon lange auf eine konsequente Digitalisierung staatlicher Dienstleistungen. Bemerkenswert ist dabei die e-Residency.

Das Angebot einer digitalen Staatsbürgerschaft zeigt, wie konsequent die Verantwortlichen in Estland die Digitalisierung umsetzen. Die e-Residency bietet Unternehmen einen einfachen und direkten Marktzugang. Im 2009 (sic!) reichte dies sogar zu einem Weltrekord: Die schnellste Zeit für die Gründung einer Rechtskörperschaft. In 18 Minuten.

Die Vorteile der estnischen Lösung liegen auf der Hand: Mit geringen Kosten können Unternehmer eine Entität gründen, welche EU-Recht untersteht. Notabene ohne ins Land zu reisen oder jemanden vor Ort damit zu beauftragen. Für die Geschäftsführung stehen eine webbasierte Buchführung mit einer Schnittstelle an die digitale Steuererklärung zur Verfügung. Will man lokale Verträge abschliessen, können sich die Vertragsparteien einer digitalen Signatur bedienen.

Also, liebe Weichensteller der Schweizer Wirtschaft: Was sind nun die Hausaufgaben um eine Eidgenössische Digitale Staatsbürgerschaft einzuführen?

Das Rückgrat bildet eine validierbare digitale Identität. Der Bundesrat hat dazu im Januar 2016 eine vernünftige Entscheidung getroffen. Bis Ende 2016 soll das EJPD eine Vernehmlassung erarbeiten, damit entsprechende Dienstleister aus dem Markt ihre Services zertifizieren lassen können. Hinsichtlich der Kadenz des technologischen Wandels macht eine marktnahe Umsetzung viel Sinn.

Ist eine eID praktikabel eingerichtet müssen die Details geregelt werden: Eine nahtlose Anbindung an die relevanten nationalen und kantonalen Behörden. Was ist dabei das grösste Risiko? Der Faktor Zeit. Den aus der estnischen Morgenröte wird in absehbarer Zeit ein Sommertag, den wir nicht verschlafen sollten.